Инновационная китайская языковая модель DeepSeek R1 вызвала ажиотаж, якобы не уступая или даже превосходя известных конкурентов, таких как OpenAI, при этом требуя значительно меньше ресурсов GPU. Какова реакция Nvidia на эту новость? Разработка R1 «замечательна» и подчеркивает растущий спрос на их чипы для ускорения ИИ.

Как геймер, я могу сказать вам, что если что-то кажется немного несбалансированным в ваших расчетах, похоже, фондовый рынок разделяет мои чувства. Только на этой неделе более полутриллиона долларов были стерты из рыночной стоимости Nvidia, заставив меня задуматься о тонкостях этих финансовых игр, которые мы называем акциями.

Давайте на мгновение задумаемся над некоторыми интересными фрагментами информации. Reuters утверждает, что DeepSeek был создан с использованием 2000 графических процессоров Nvidia H800 и имел бюджет обучения всего в 6 миллионов долларов. С другой стороны, CNBC утверждает, что R1 превосходит лучшие модели изучения языка от таких компаний, как OpenAI и других, по производительности.

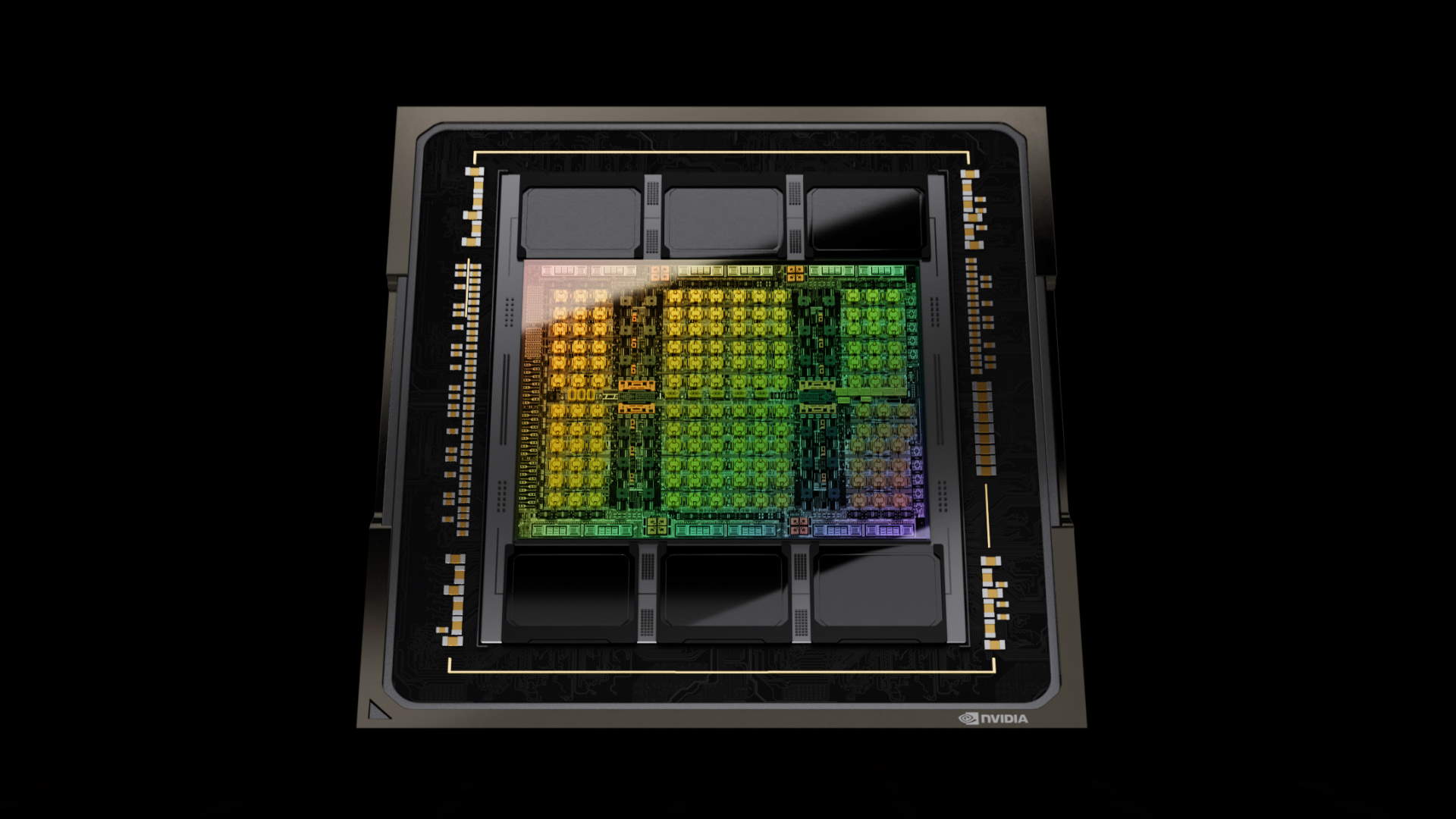

H800 — это модифицированная версия графического процессора Hopper H100 от Nvidia, разработанная для соответствия ограничениям США на экспорт чипов ИИ. Некоторые эксперты в секторе искусственного интеллекта предполагают, что Китай, и в частности DeepSeek, нашли способы обойти эти экспортные правила, чтобы получить большие партии более мощных графических процессоров H100 от Nvidia. Однако Nvidia опровергла это утверждение.

Как геймер, я могу сказать, что при обучении последней версии ChatGPT (ChatGPT 4) OpenAI использовала около 25 000 графических процессоров предыдущего поколения Nvidia A100. По сравнению с другим оборудованием, таким как H800, сложно проводить прямые сравнения, но, похоже, DeepSeek удалось достичь большего с меньшим количеством графических процессоров в этом сценарии.

Похоже, на рынке возникла неопределенность относительно Nvidia, предполагающая, что для революции в области искусственного интеллекта (ИИ) может потребоваться не так много чипсетов, как предполагалось изначально.

Без сомнения, Nvidia смотрит на вещи по-другому, восхваляя R1 за демонстрацию эффективности метода масштабирования «Test Time» в построении более сильных моделей ИИ. По их словам для CNBC, «DeepSeek действительно представляет собой значительный шаг вперед в области ИИ и является идеальной демонстрацией масштабирования Test Time». Они также отметили, что разработка DeepSeek подчеркивает, как эта техника может быть использована для построения новых моделей, используя широко доступные модели и вычислительные ресурсы, которые соответствуют правилам экспортного контроля.

Возможно, все не так просто, как кажется. Вчера Энди поделился, что, по некоторым оценкам, DeepSeak может тратить от полумиллиарда до миллиарда долларов в год. Однако, похоже, DeepSeak достигает большего с меньшими инвестициями по сравнению с ветеранами отрасли.

Например, Microsoft планирует инвестировать около $80 млрд в оборудование искусственного интеллекта (ИИ) в этом году, в то время как Meta заявила, что потратит от $60 до $65 млрд. Модель R1 от DeepSeek предполагает, что сопоставимые результаты могут быть достигнуты при значительно меньших затратах, потенциально всего лишь за часть инвестиций, упомянутых выше.

Подразумевается ли, что покупка меньшего количества графических процессоров приводит к результатам при рассмотрении ситуации? Однако это может быть не так. Учитывая крупные инвестиции, сделанные такими компаниями, как Microsoft и Meta, становится ясно, что только ограниченное число организаций могут позволить себе участие из-за непомерно высоких затрат.

Сокращение его по крайней мере в десять раз может значительно увеличить число возможных участников, и многим из них потребуются графические процессоры. Это чем-то похоже на переход от мэйнфреймов к персональным компьютерам. Хотя каждая инвестиция в персональные компьютеры была значительно меньше, общий размер вычислительной отрасли значительно увеличился.

Возможно, DeepSeek знаменует собой поворотный момент. После этого момента достижения в области искусственного интеллекта могут стать более демократичными, с ослабленным контролем со стороны всего нескольких чрезвычайно богатых групп, что потенциально будет способствовать созданию более эгалитарной среды для его развития.

Возможно, в конечном итоге окажется, что DeepSeek действительно использовал огромное количество H100. Независимо от этого, Nvidia наверняка планирует накопить огромную сумму — наличных денег.

Смотрите также

- Читы Stardew Valley: каждый необходимый вам чит-код, никаких модов не требуется.

- Мертвая тварь (2024) [Кинофестиваль Fantasia 2024]

- Руководство FC 25 по различным построениям и индивидуальной тактике

- Лучшие слайдеры NHL 25 и как их использовать

- Ничего страшного, если вы не до конца поняли эпизод «73 ярда» Доктора Кто — вы никогда не должны были это понимать.

- Читы Bellwright и консольные команды

- Я даже не автолюбитель, но игра Tokyo Xtreme Racer ’25, которая вернулась в эпоху 2000 года, выглядит невероятно и имеет тысячи исключительно положительных отзывов в Steam после 4 дней раннего доступа.

- Консольные команды Сталкера 2 и чит-моды

- Вышла 4-я глава Poppy Playtime, так что приготовьтесь встретиться с «Доуи-Печенькой» и узнать, действительно ли он «веселый до самой смерти»

- Обзор беспроводного контроллера 8BitDo Ultimate 2C

2025-01-28 19:32