Как геймер, я понял, что ИИ иногда сталкивается с тем, что мы называем ‘галлюцинациями’. Однако это не обычные галлюцинации. Видите ли, искусственный интеллект не обладает глубоким пониманием контекста или смысла, как люди. Вместо этого он предсказывает следующие слова на основе паттернов, что может привести к созданию недостоверной информации. От ошибочных фактов о сыре до сомнительных медицинских советов – такая дезинформация может показаться забавной, но она далека от безобидности и может иметь потенциальные юридические последствия.

Арве Хьялмар Холмен, норвежец, вступил в разговор с искусственным интеллектом под названием ChatGPT для того, чтобы узнать, какую информацию он предоставит, если ему задать свое имя. Удивление вызвало то, что ChatGPT представил неправдоподобную историю о убийстве своих сыновей и 21-летнем тюремном заключении (согласно TechCrunch). Особую тревогу вызывало включение в этот фиктивный рассказ точных деталей личной жизни Холмена: числа детей, их пола и названия родного города.

Ноб быстро присоединился к дискуссии о спорных результатах работы ChatGPT. В интервью TechCrunch группа объяснила, что провела собственное расследование, чтобы выяснить, не мог ли другой человек с похожим именем быть ответственным за серьезные обвинения. Однако они не смогли обнаружить существенных доказательств в этом направлении, оставив причину тревожных заявлений ChatGPT неизвестной.

После обновления своего основного ИИ чат-бот больше не делает порочащих заявлений. Однако Нобиа, который ранее подавал жалобы из-за неточностей в информации от ChatGPT о публичных личностях, остался недоволен этим решением и подал жалобу в Data Protection Authority (норвежский орган по защите данных) о предполагаемом нарушении GDPR правил.

В соответствии со Статьей 5(1)(d) законодательства ЕС предприятия, работающие с персональными данными, обязаны обеспечить их точность. Если информация неверна, они должны либо исправить её, либо удалить. NOYB утверждает, что простое прекращение ложного обвинения, например ChatGPT больше не называет Холмена убийцей, не означает автоматического удаления неточных данных.

Ноби указал на то, что ‘неверная информация может сохраниться в базе данных LLM, так как ChatGPT автоматически использует данные пользователей для обучения. Следовательно, нет уверенности в том, что отдельное лицо сможет полностью удалить свои данные из системы, за исключением случаев, когда вся модель ИИ требует повторного обучения.’

Согласно Nob, базовая структура ChatGPT не соответствует требованиям статьи 15 GDPR, что означает отсутствие гарантии того, что вы можете получить или отслеживать информацию, которую вводите в ChatGPT, а также данных о вас, использованных в обучающем наборе данных. Этот аспект продолжает вызывать беспокойство у заявителя Хольмена.

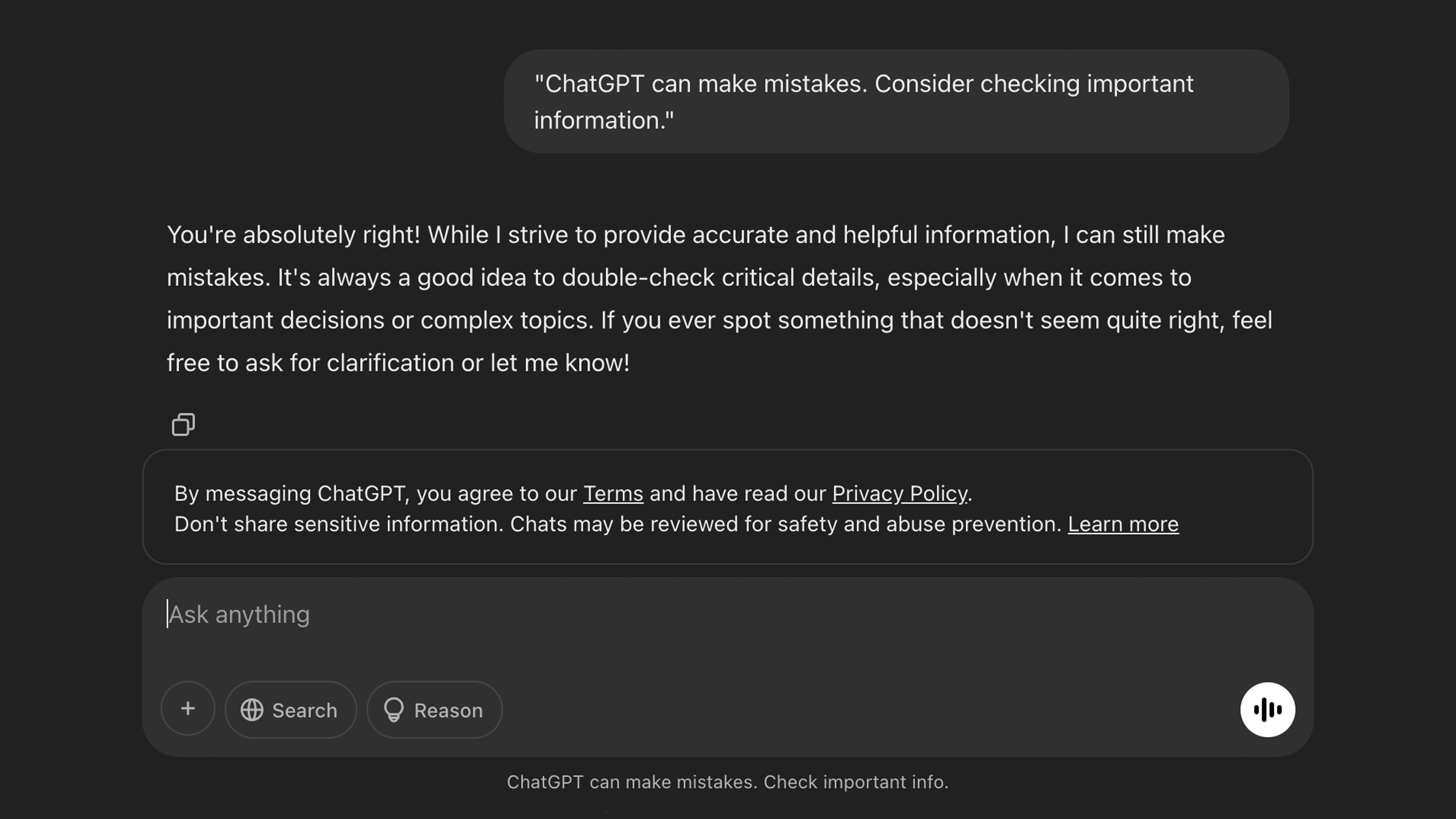

В настоящее время Noyb призывает DataTilsynet дать указания OpenAI об удалении любых неверных данных, связанных с Holmen, и предотвратить создание ChatGPT дополнительных волнующих историй о других людях. Однако учитывая, что OpenAI показывает лишь небольшое предупреждение в нижней части каждого сеанса пользователя: «ChatGPT может допускать ошибки. Пожалуйста, проверяйте важную информацию», это может оказаться довольно сложной задачей.

Тем не менее, обнадеживающе наблюдать использование законных тактик Noyb против OpenAI, учитывая то, что правительство США, похоже, действует безрассудно с планом инфраструктуры искусственного интеллекта ‘Stargate’, полностью пренебрегая осторожностью. Это вызывает беспокойство, когда такой инструмент, как ChatGPT, легко генерирует потенциально клеветнические утверждения наряду с фактическими данными. В таких условиях даже намек на осторожность кажется недостаточным.

Лучший игровой ПК: Лучшие готовые сборки.

Лучший игровой ноутбук: Отличные устройства для мобильных игр.

Смотрите также

- Мод Community Shaders для Skyrim Special Edition только что вышел в версии 1.0 и стал важным графическим обновлением.

- Черноглазая Сьюзен (2024) [Кинофестиваль Fantasia 2024]

- Коды ошибок Throne и Liberty и как их исправить

- Читы Stardew Valley: каждый необходимый вам чит-код, никаких модов не требуется.

- Обзор Asus ROG Maximus Z890 Hero

- Обзор MSI RTX 5070 Ti Gaming Trio OC Plus

- Обзор Anycubic Kobra 3 Combo

- Обзор MSI Stealth 18 AI Studio: «пойман посередине»

- Все преимущества предметов экзотического класса Destiny 2 для призматических сборок

- Обзор контроллера GameSir Nova Lite

2025-03-20 18:32